Apple M1 환경

brew 업데이트

terminal 환경에서

brew updatePython 다운로드 혹은 업그레이드

terminal 환경에서

# 파이썬 3.9버전 다운로드

brew install python@3.9

# 파이썬 3.9버전 업그레이드

brew upgrade python@3.9JAVA 11 다운로드

brew tap adoptopenjdk/openjdk

brew search jdk

brew install --cask adoptopenjdk11JAVA 다운로드 확인

/usr/libexec/java_home -V

vi ~/.zshrc # 이곳에 위 자바 홈 추가

java --versionbrew install scala

brew install apache-spark

brew install --cask anaconda

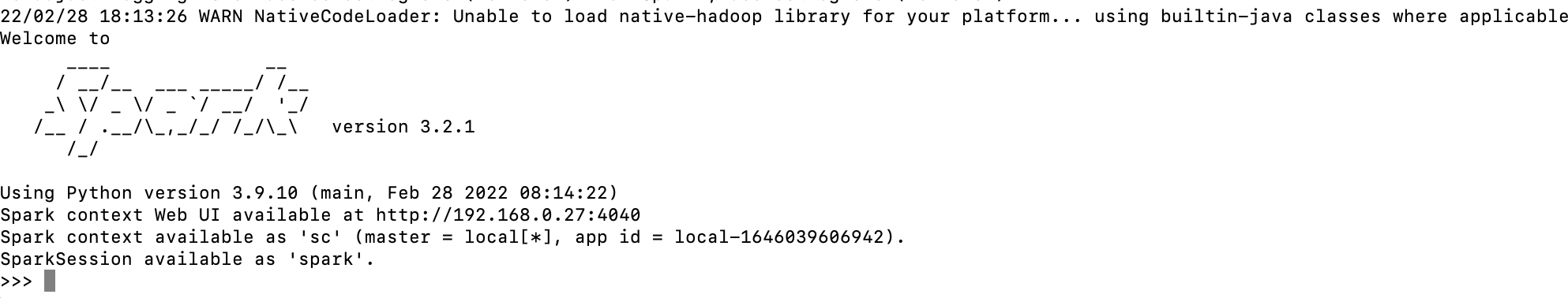

spark 테스트

터미널 창에 pyspark

위와 같이 뜨면 성공!~

만약, 에러시,

https://itholic.github.io/etc-sparkdriver-retires-err/

윈도우10 환경

1. 자바 설치

반드시 java 8 혹은 java 11을 설치햐야 한다.

2. 스파크 설치

- WInRAR 설치

- Spark 3.x 버전 설치

3. 컴퓨터에 Hadoop이 있다고 속이기

1) 다음 경로에 폴더 생성

- C:\winutils\bin

- C:\tmp\hive

2) 파일 다운로드 & 이동

C:\winutils\bin에 https://sundog-spark.s3.amazonaws.com/winutils.exe들어가서 다운받기

3) 테스트

cmd화면에서

cd C:\\winutils\\bin

winutils.exe chmod 777 \\tmp\\hive 오류없이 실행되면 끝

4) 환경변수 설정

윈도우 - 설정 - 시스템 - 정보 - 고급 시스템 설정 - 환경변수 설정

- JAVA_HOME

c:\jdk - SPARK_HOME

C:\spark - PYSPARK_PYTHON

anaconda cmd 창 들어가서

python -> import sys -> sys.executable 입력 - HADOOP_HOME

winutils 위치 - PATH

PATH라고 등록된 환경변수 안으로 들어가서

NEW 클릭후

%JAVA_HOME%\bin

%SPARK_HOME%\bin

%HADOOP_HOME%\bin

5) 파이스파크 설치

관리자 아나콘다 프롬프트에서

pip install pyspark6) 테스트

이후 cmd 창에서

pysprk

rdd =sc.textFile("README.md")

rdd.copunt()결과값으로 109나오면 성공

출처: https://wind010.hashnode.dev/setting-up-anaconda-and-pyspark-on-m1-mac